生成式 AI 正在快速滲透各行各業,從客服自動化到內容生成,都能看到 LLM(大型語言模型)的應用。然而,當企業需要讓模型更貼近特定場景時,僅依賴 API 調用或 Hugging Face Hub 上的公開模型,往往難以完全滿足需求。尤其在醫療診斷輔助、法律摘要、財務分析等高專業度場景,模型必須能準確理解專業術語、遵循嚴格格式或解析結構化數據,而通用模型往往難以同時兼顧成本與準確性。

在 LLM 商業化的實務中,企業通常有兩條路可選:

直接調用外部 API

自行微調模型

隨著需求朝專業化發展,微調(Fine-tuning)逐漸成為更務實的選擇。這裡的「務實」並非僅指便宜,而是因為它能在長期降低推論成本、強化模型品質、保障資料安全,比起單純依賴 API,更能滿足企業的實際運營需求。

雖然微調能透過相對少量的資料讓模型更貼近業務需求,但實務上並不只是「執行一段訓練腳本」這麼簡單,背後涉及多重挑戰:

這些痛點正是推動「平台化微調系統」出現的原因。透過統一平台,可以將資料處理、訓練、部署與監控整合成一條高可觀測性、高可維護性的流程,為模型上線提供穩定基礎。

面對這些問題,平台化是更高效的解決方式。將各流程納入同一平台能帶來:

因此,本系列文章的目標,是從零實作一個 LoRA/QLoRA 微調平台,並完整記錄從需求分析到系統落地的過程。我希望透過這個專案,一方面在實務中強化技術能力,另一方面累積一個可實際運行的作品,成為未來履歷與專案展示的亮點。

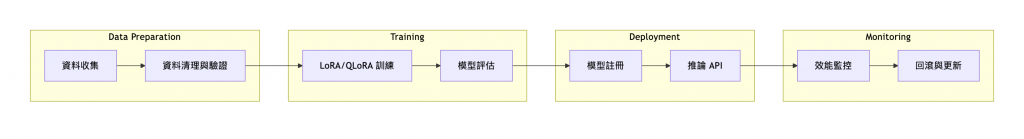

以下為本平台的核心流程:

flowchart LR

subgraph Data Preparation

A[資料收集] --> B[資料清理與驗證]

end

subgraph Training

B --> C[LoRA/QLoRA 訓練]

C --> D[模型評估]

end

subgraph Deployment

D --> E[模型註冊]

E --> F[推論 API]

end

subgraph Monitoring

F --> G[效能監控]

G --> H[回滾與更新]

end

微調不再只是學術研究中的實驗,而是企業邁向生成式 AI 商業化過程中的必經步驟。雖然它伴隨成本與技術挑戰,但透過平台化的方式,這些挑戰能轉化為標準化流程,讓 AI 真正落地並創造價值。

接下來的系列文章,我將逐步拆解如何設計並實作一個 LoRA/QLoRA 微調平台,從資料準備、訓練管理、部署到監控,打造一個具備實務價值的完整系統。如果你也想知道 「如何讓 AI 從 demo 走向生產環境」,這個系列將會是最直接的指南。

感謝版主精闢的分析!這篇文章深刻點出了通用 LLM 在高專業度場景的限制,以及為何微調會是企業走向 AI 商業化的必經之路。特別認同您提到「平台化」是解決實務上諸多挑戰,如成本、流程與版本追蹤的關鍵解法。

我很期待您後續系列文,能深入分享如何從零打造這樣一個 LoRA/QLoRA 微調平台。尤其對於平台中「模型與資料的版本追蹤與回溯」這塊,在實務落地時格外重要,很想請教版主會如何設計其架構與實現方式呢?再次感謝您的寶貴分享!

也歡迎版主有空參考我的系列文「南桃AI重生記」:

https://ithelp.ithome.com.tw/users/20046160/ironman/8311